Independencia económica: ¿por qué es importante el plan de previsión dentro de mi plan financiero?

Planificar es clave para ganar autonomía si sufrimos una dependencia

Planificar es clave para ganar autonomía si sufrimos una dependencia

La compraventa de la nuda propiedad de vivienda ha crecido un 11% en 2023

Las emociones marcan las decisiones de inversión e influyen en el comportamiento del mercado

Saber los impuestos de cada producto financiero es importante, pero el ahorrador debe mirar más allá

El Retorno sobre el Capital Empleado

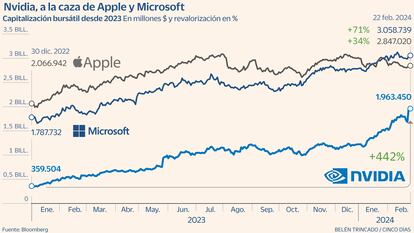

¿Es buen momento para invertir en tecnología?

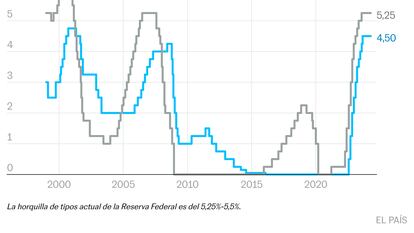

Nuestro escenario central para 2024 es de tipos todavía altos

Las mejores estrategias de inversión en IA desde la perspectiva de un desarrollador

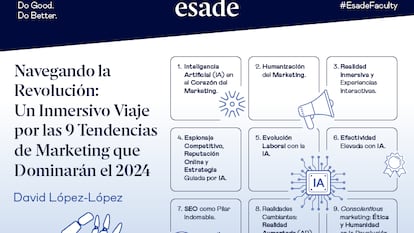

Nueve claves definen un panorama donde la inteligencia artificial y la humanidad convergen en un ballet estratégico

La única forma de tener libertad financiera es ahorrar.

No se trata de vender, negociar o influenciar, sino de colaborar

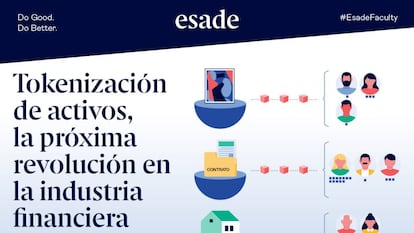

Tokenización de activos, la próxima revolución en la industria financiera.

Va a haber altos niveles de volatilidad y apetito por la gestión activa.

La dirección es favorable

Selectivos en renta variable

Selectivos en renta variable

El deber de impulsar la competitividad y la sostenibilidad de las empresas a través de una mejor configuración institucional

Thierry Carcel (Vienne, 1967) es un lider optimista, positiva y agradecido. En nuestra conversación hablamos de liderazgo, del rol del CEO en la innovación y también de cuestiones muy variadas como la importancia de los valores o la felicidad

La mitad de las compañías han cambiado a su CEO en los últimos tres años

La transformación de la inteligencia artificial y su impacto en el liderazgo empresarial